Gérer une boutique en ligne est passionnant - jusqu'au jour où elle est mise hors ligne.

Il s'agit peut-être d'un pic de trafic soudain.

Peut-être que l'hébergeur a des problèmes.

La mise à jour d'un plugin ne s'est peut-être pas déroulée comme vous l'espériez.

Quelle qu'en soit la raison, les temps d'arrêt font mal. Chaque minute d'indisponibilité d'un magasin empêche les clients de faire leurs achats, les publicités continuent à être dépensées, les paniers sont abandonnés et la réputation que vous avez travaillé dur à construire en prend un coup.

Si vous êtes propriétaire d'une boutique Shopify ou WooCommerce, ou si vous gérez une boutique entièrement codée sur mesure, la surveillance du temps de fonctionnement n'est pas seulement un détail technique - c'est une protection des revenus. Dans ce guide, nous allons expliquer ce qu'est la surveillance du temps de fonctionnement, pourquoi elle est importante et comment les propriétaires de boutiques (même ceux qui ne sont pas des techniciens) peuvent la mettre en œuvre correctement.

Pourquoi la surveillance du temps de fonctionnement est plus importante que vous ne le pensez pour le commerce électronique ?

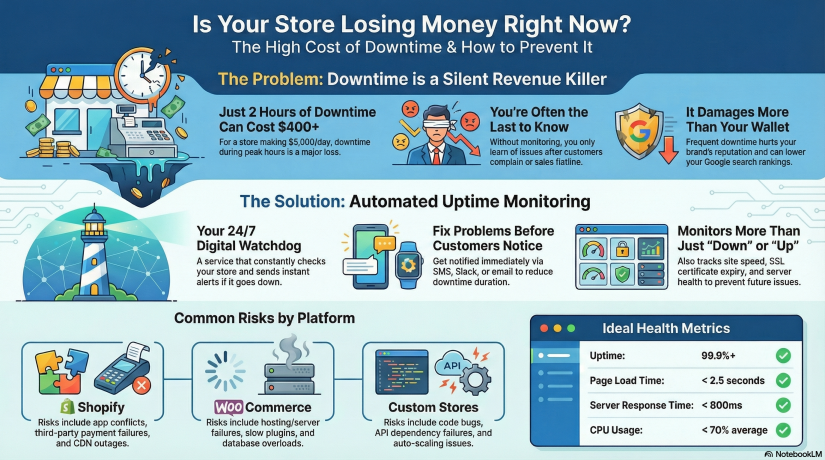

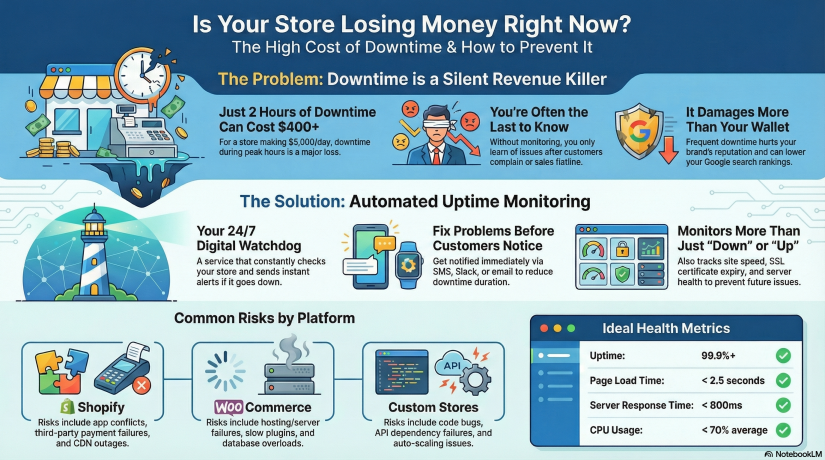

Dressons un rapide tableau de la situation.

Imaginez que votre magasin fasse $5 000/jour dans les ventes.

C'est à peu près $208/heure.

Imaginez maintenant que votre magasin soit fermé pour une durée de 2 heures aux heures de pointe.

Vous venez de perdre plus de $400 sans même savoir que cela s'est produit - et les clients qui ont essayé d'acheter chez vous risquent de ne pas revenir.

Il s'agit maintenant d'augmenter ce chiffre lors d'événements tels que.. :

-

Vendredi noir / Cyber lundi

-

Lancement du produit

-

Moment de viralité dans les médias sociaux

-

Campagne de publicité payée

-

Email marketing blast

-

Ruée vers les fêtes de fin d'année

Lors d'événements à forte affluence, 30 minutes de temps d'arrêt peuvent coûter des milliers d'euros.

C'est pourquoi la surveillance du temps de fonctionnement est essentielle. Il vous permet de :

- Sachez instantanément si votre magasin est en panne - avant que vos clients ne le sachent

- Réduire les temps d'arrêt grâce à une réponse plus rapide aux incidents

- Prévenir les pertes de revenus et protéger la confiance dans la marque

- Suivre les performances au fil du temps grâce à des mesures de contrôle réelles

- Fiabilité - important pour le référencement et la fidélisation des clients

Google tient même compte de la fiabilité des sites pour leur classement. Les moteurs de recherche n'aiment pas les sites Web peu fiables. Si les robots d'indexation trouvent votre boutique en panne à plusieurs reprises, votre classement ne sera pas bon. peut baisse.

Qu'est-ce que la surveillance du temps de fonctionnement ?

La surveillance du temps de disponibilité est un service qui vérifie constamment votre site web pour s'assurer qu'il est accessible et qu'il fonctionne. En cas de défaillance - panne de serveur, problème de DNS, panne de la passerelle de paiement - vous êtes immédiatement informé par e-mail, SMS, push, Slack, Telegram ou d'autres canaux.

Le contrôle du temps de fonctionnement est considéré comme Sécurité 24/7 pour votre activité en ligne.

La plupart des propriétaires de sites web pensent que l'hébergement inclut la surveillance. Ce n'est pas le cas. Les sociétés d'hébergement ne garantissent que le temps de fonctionnement de l'infrastructure (dans une certaine limite), mais elles ne vous alertent pas activement lorsque votre site est en panne.

Grâce à la surveillance du temps de fonctionnement, vous saurez :

✔ Quand votre site web devient inaccessible

Lorsque les temps de réponse ralentissent

✔ Si SSL est sur le point d'expirer

✔ Si les ressources du serveur sont surchargées

✔ Si des plugins ou des thèmes provoquent une défaillance

Sans suivi, vous ne le saurez qu'après que les clients se seront plaints - ou pire, après avoir consulté votre tableau de bord des recettes et constaté que quelque chose ne va pas.

Shopify vs WooCommerce vs Custom Stores - Différentes boutiques, différents risques

Décortiquons les risques typiques auxquels chaque plateforme est confrontée.

Magasins Shopify

Shopify est stable, hébergé et gère l'infrastructure - mais cela ne signifie pas que les pannes ne peuvent pas se produire. Les risques sont les suivants :

-

Conflits de thèmes ou d'applications

-

Coupures de CDN

-

Temps d'arrêt régional

-

Défauts de paiement des tiers

-

Mauvaise configuration du DNS

-

Magasin désactivé en raison de problèmes de facturation ou de politique

Shopify s'occupe de l'hébergement, vous devez vous occuper de la surveillance.

Magasins WooCommerce (WordPress)

WooCommerce vous donne plus de contrôle - mais ce contrôle s'accompagne de responsabilités. Les risques :

-

Temps d'arrêt de l'hébergement/du serveur

-

Ralentissement des performances dû à des plugins lourds

-

Problèmes de mise en cache

-

Certificats SSL expirés

-

Vulnérabilité ou attaques de logiciels malveillants

-

Surcharge de la base de données lors des pics de trafic

Les boutiques WooCommerce doivent surveiller serveur + site web + SSL + DNS + performance.

Magasins sur mesure

La personnalisation est illimitée, mais aussi imprévisible. Les risques sont les suivants :

-

Bugs ou problèmes de déploiement

-

Défaillances des dépendances API (les défaillances de Stripe/PayPal interrompent le paiement)

-

Instabilité de l'hébergement ou du VPS

-

Mauvaises configurations du cache

-

Échec de la mise à l'échelle automatique

-

Cron jobs breaking

-

Erreurs de code personnalisé

Les magasins à l'unité ont besoin de la l'approche de surveillance la plus complète.

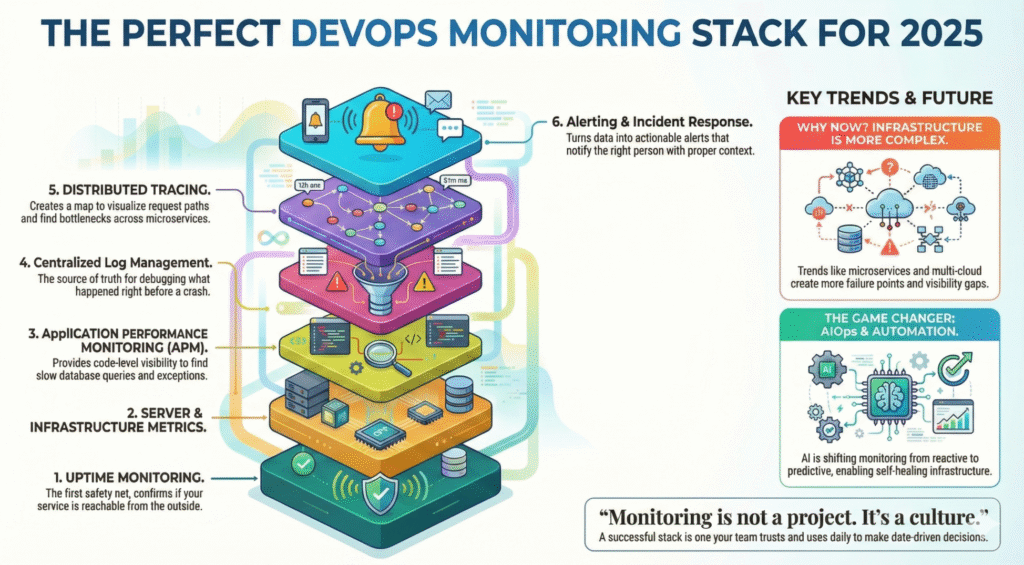

Les 3 niveaux de surveillance dont chaque magasin a besoin

1. Surveillance de la disponibilité du site web

Vérifie votre URL dans plusieurs régions toutes les X secondes.

Un bon contrôle ne se limite pas à vérifier si la page est en train de se charger. Il testera :

En cas de panne, vous êtes alerté en quelques minutes.

2. Surveillance du serveur/hébergement (WooCommerce & Custom Stores)

Suivre des mesures d'infrastructure plus approfondies telles que

| Métrique |

Pourquoi c'est important |

| Utilisation de l'unité centrale |

Les pics d'activité entraînent des lenteurs de paiement et des pannes |

| RAM |

WordPress + plugins = gourmands en mémoire |

| Disque |

Disque plein = le site s'arrête instantanément |

| Réseau |

Perte de paquets = interruptions régionales |

| Moyenne de la charge |

Prévoir la dégradation des performances |

C'est là que des plateformes comme Xitoring deviennent utiles.

Vous pouvez surveiller les deux temps de disponibilité + santé du serveur en un seul endroit, Vous pouvez ainsi détecter les problèmes à un stade précoce - avant que le site ne tombe en panne.

3. SSL, DNS et surveillance des domaines

Ce sont de petites choses que les propriétaires de magasins oublient, mais qui cassent les sites instantanément :

-

Expiration du SSL = les navigateurs bloquent les visiteurs

-

Mauvaise configuration du DNS = site inaccessible

-

Expiration du domaine = entreprise hors ligne du jour au lendemain

Votre boutique est peut-être parfaite - mais SSL a expiré = site web mort.

Le contrôle permet d'éviter cela.

Comment fonctionnent les outils de surveillance du temps de fonctionnement (décomposition simple)

Voici ce qui se passe à l'intérieur d'un système de surveillance du temps de fonctionnement :

-

Vous ajoutez l'URL de votre magasin au tableau de bord

-

Le moniteur interroge votre site à partir de différentes régions du monde toutes les quelques secondes/minutes.

-

En cas d'échec (timeout/500 error/réponse lente/problème SSL), un deuxième site vérifie

-

Une fois confirmées, les notifications sont envoyées instantanément

-

Un rapport détaillé indique la durée, la cause et le temps de résolution.

Cela signifie que vous n'avez pas besoin de vérifier constamment votre site manuellement - le système le surveille pour vous.

Mise en place d'une surveillance pour votre magasin - étape par étape

Même si vous n'êtes pas un technicien, l'installation est simple.

Pour les boutiques Shopify

Aucune installation de serveur n'est nécessaire - il suffit de surveiller l'URL de la page d'accueil.

-

Ajouter le domaine de votre magasin

-

Choisir les canaux d'alerte (email/SMS/Telegram/Slack)

-

Permettre la surveillance du temps de réponse

-

Ajouter le contrôle de l'expiration du SSL

-

Définir les intervalles de contrôle (1-5 minutes recommandé)

Étape avancée facultative : surveillance d'URL spécifiques (page de paiement, page d'ajout au panier, page de paiement)

Pour les boutiques WooCommerce

Vous devez surveiller site web + serveur + base de données.

-

Ajoutez le domaine de votre magasin pour vérifier le temps de fonctionnement

-

Installer l'agent serveur (si vous utilisez un hébergement VPS)

-

Surveiller l'utilisation des ressources (CPU/RAM/Disk)

-

Ajouter un moniteur de base de données MySQL

-

Activer l'alerte de mise à jour de plugin/thème

-

Surveiller les points d'extrémité de l'API REST

-

Ajouter la surveillance SSL et DNS

Bonus : créer un page d'état pour afficher publiquement l'historique des temps de fonctionnement.

Pour les magasins personnalisés

Créer une configuration multicouche :

-

Surveillance de la durée de fonctionnement de HTTP

-

Surveillance Ping

-

Surveillance des ports (80/443/DB/Redis)

-

Journaux des ressources du serveur

-

Surveillance des points d'extrémité de l'API

-

Surveillance des tâches et des files d'attente Cron

-

Tests synthétiques pour les flux clés

Un exemple de test simple :

Un utilisateur peut-il ajouter un produit → passer à la caisse → effectuer le paiement ?

La surveillance synthétique permet de simuler cela automatiquement.

Comment Xitoring peut aider (exemple naturellement intégré)

Si de nombreux outils permettent de surveiller les sites web, les boutiques de commerce électronique tirent le meilleur parti d'une plateforme qui prend en charge les éléments suivants à la fois le temps de disponibilité + la surveillance du serveur + les alertes + les pages d'état - le tout ensemble.

Xitoring vous permet de :

-

Ajouter des vérifications du temps de fonctionnement pour les boutiques Shopify/WooCommerce/Custom

-

Surveillez l'unité centrale, la mémoire vive, les disques et le réseau de vos serveurs.

-

Créer un espace public ou privé pages d'état

-

Recevoir des alertes par e-mail, SMS, Slack, Telegram et plus encore

-

Détecter les anomalies à l'aide d'informations alimentées par l'IA

-

Éviter les temps d'arrêt grâce à des alertes automatisées avant qu'une panne ne se produise

Au lieu de jongler avec plusieurs outils, vous obtenez une vue d'ensemble de la santé de votre magasin.

Il ne s'agit pas d'une promotion, mais d'un exemple réaliste de la manière dont les propriétaires de magasins réduisent le stress lié aux temps d'arrêt.

Scénarios réels de temps d'arrêt et comment la surveillance vous sauve la mise

Scénario 1 - Un pic de trafic fait chuter WooCommerce

Vendredi noir + hébergement mutualisé = surcharge du serveur.

Sans surveillance :

Vous ne vous en apercevez qu'après avoir reçu des courriels de mécontentement ou après que les ventes ont chuté.

Avec surveillance :

Alerte en cas de pic de CPU/RAM → augmentation de la puissance du serveur → temps d'arrêt évité.

Scénario 2 - L'application Shopify interrompt le processus de paiement

Une application de vente incitative récemment installée entre en conflit avec votre thème.

La surveillance permet de détecter une augmentation des temps de réponse et des échecs de vérification. Vous restaurez rapidement les sauvegardes - pas de perte importante de revenus.

Scénario 3 - Le SSL d'un site personnalisé expire

Les avertissements du navigateur tuent les conversions. Facilement évitable.

La surveillance vous alerte des jours ou des semaines à l'avance. La crise est évitée.

Les indicateurs clés de performance (KPI) que les propriétaires de magasins doivent suivre

Rester stable et rapide :

| ICP |

Cible idéale |

| Temps de fonctionnement |

99,9%+ minimum |

| Temps de chargement des pages |

< 2,5 secondes |

| Temps de réponse |

< 800 ms en moyenne |

| Expiration du SSL |

> 30 jours avant le renouvellement |

| Utilisation de l'unité centrale |

< 70% charge moyenne |

| Taux d'erreur |

Aussi proche que possible de 0% |

Même les débutants peuvent les suivre.

Meilleures pratiques pour garder votre magasin en ligne et rapide

- Surveillance 24 heures sur 24, 7 jours sur 7 - ne vous fiez pas aux contrôles manuels

- Tester le temps de fonctionnement à partir de plusieurs sites dans le monde

- Contrôler les flux d'utilisateurs critiques, et pas seulement la page d'accueil

- Utiliser un CDN et la mise en cache pour des temps de réponse plus rapides

- Surveillez toujours l'expiration des SSL, DNS et domaines

- Maintenir les plugins/thèmes à jour et sécurisés

- Définir des alertes sur plusieurs canaux (e-mail + SMS/Telegram)

Un outil de surveillance est comme votre ceinture de sécurité. Vous espérez ne jamais en avoir besoin, mais lorsque c'est le cas, il vous sauve.

À la fin !

Que votre boutique en ligne fonctionne sur Shopify, WooCommerce ou une plateforme personnalisée, la surveillance du temps de fonctionnement est l'une des mesures les plus simples et les plus intelligentes pour protéger votre chiffre d'affaires. Les temps d'arrêt finiront par se produire - ce qui compte, c'est la rapidité avec laquelle vous vous en apercevez et la rapidité avec laquelle vous les corrigez.

Le contrôle ne se limite pas à l'infrastructure technique - c'est la protection de l'entreprise.

Il s'agit de préserver la réputation.

Il s'agit d'une assurance-revenu.

Et heureusement, il est aujourd'hui plus facile que jamais de le mettre en place.

Prenez 10 minutes, ajoutez une configuration de surveillance, connectez des alertes - vous vous en féliciterez à l'avenir.